#Business #Introductions

Meet LLMs.txt · A proposed standard for AI website content crawling https://ilo.im/16318s

_____

#SEO #GEO #AI #Bots #Crawlers #LlmsTxt #RobotsTxt #Development #WebDev #Backend

#Business #Introductions

Meet LLMs.txt · A proposed standard for AI website content crawling https://ilo.im/16318s

_____

#SEO #GEO #AI #Bots #Crawlers #LlmsTxt #RobotsTxt #Development #WebDev #Backend

Search Engine Land: Meet LLMs.txt, a proposed standard for AI website content crawling. “While many content creators are interested in the proposal’s potential merits, it also has detractors. But given the rapidly changing landscape for content produced in a world of artificial intelligence, llms.txt is certainly worth discussing.”

A new `/llms.txt` file has been proposed to standardize how LLMs interact with websites. This Markdown file, placed in the root directory, provides brief background info, guidance, and links to detailed files, helping LLMs quickly understand key content and process website information. Companies like Anthropic are already adopting this standard, further fueling the rise of unreliable AI search engines.

Der llms.txt-Standard und das Aufkommen der Mensch-KI-Infrastruktur

Das World Wide Web steht an der Schwelle eines tiefgreifenden Wandels. Ein neues Proposal namens llms.txt signalisiert das Entstehen von etwas Bemerkenswertem: ein Web, das nicht nur menschlichen Lesern, sondern auch künstlichen Intelligenzen als Bürgern erster Klasse dient. Dies ist nicht nur ein weiterer technischer Standard - es ist der Beginn eines grundlegenden Wandels in unserem Denken über digitale Infrastrukturen.

Was diesen Moment so bedeutsam macht, ist nicht nur die technische Spezifikation, sondern auch das, was er bedeutet: die Erkenntnis, dass KI-Agenten zu primären Konsumenten von Webinhalten werden, nicht nur zu Vermittlern. Da sich diese Agenten von einfachen Crawlern zu Entscheidungsträgern entwickeln, muss sich unsere Web-Infrastruktur mit ihnen weiterentwickeln.

Eine Geschichte von zwei Netzen

Wenn Sie eine moderne Website besuchen, haben Sie es mit mehreren Inhaltsschichten zu tun. Die sichtbare Ebene - das, was Sie in Ihrem Browser sehen - ist ein reichhaltiges Mosaik aus HTML, CSS und JavaScript, der sorgfältig für den menschlichen Konsum gestaltet wurde. Aber unter dieser Oberfläche liegt ein anderes Web, eines, das für Maschinen entwickelt wurde: APIs, strukturierte Daten und maschinenlesbare Formate, die Suchmaschinen und anderen automatisierten Systemen helfen, die Inhalte zu verstehen.

Diese Dualität besteht schon seit den Anfängen der Suchmaschinen, als Standards wie robots.txt und sitemap.xml entwickelt wurden, um Crawlern die Navigation im Web zu erleichtern. Doch heute erleben wir das Aufkommen einer dritten Ebene: eine, die speziell für KI-Agenten entwickelt wurde, die Inhalte nicht nur indizieren, sondern aktiv konsumieren, verarbeiten und darauf reagieren.

Der llms.txt-Standard: Eine Brücke zwischen den Welten

Der von Jeremy Howard vorgeschlagene Standard llms.txt veranschaulicht diese Entwicklung perfekt. Es ist eine elegante Lösung für ein komplexes Problem: Wie können wir KI-Agenten dabei helfen, Webinhalte effizient zu verarbeiten und gleichzeitig die menschliche Lesbarkeit zu erhalten? Der Standard schlägt einen einfachen, aber wirkungsvollen Ansatz vor - eine Markdown-Datei im Stammverzeichnis von Webservern, die KI-freundliche Versionen der wichtigsten Inhalte bereitstellt.

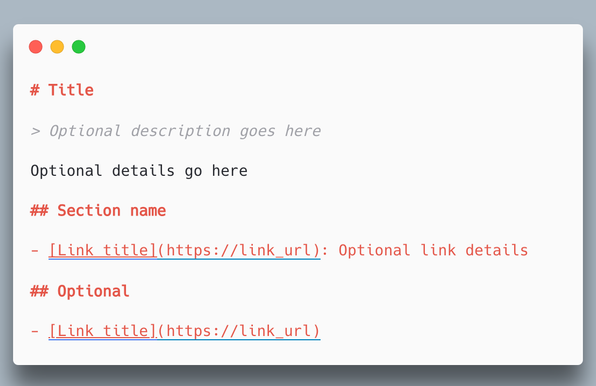

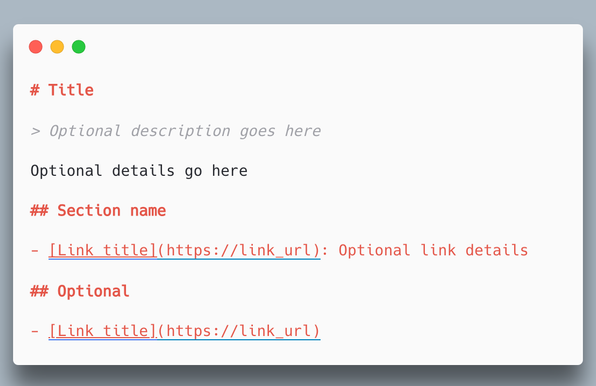

Die technische Struktur von llms.txt ist es wert, im Detail betrachtet zu werden. Im Gegensatz zu herkömmlichen maschinenlesbaren Formaten wie XML oder JSON wird hier Markdown verwendet - ein Format, das ein ausgewogenes Verhältnis zwischen menschlicher und maschineller Lesbarkeit herstellt. Die Spezifikation erfordert eine präzise Struktur:

Auf der obersten Ebene beginnt jede llms.txt-Datei mit einer H1-Überschrift, die den Namen der Website oder des Projekts enthält, gefolgt von einem Blocksatz, der die wichtigsten Informationen kurz zusammenfasst. Dabei geht es nicht nur um die Organisation, sondern auch um die effiziente Bereitstellung von Kontext innerhalb des begrenzten Kontextfensters der aktuellen KI-Modelle.

Die eigentliche Innovation liegt in der Art und Weise, wie der Standard den Inhalt organisiert. Nach der anfänglichen Zusammenfassung kann die Datei mehrere Abschnitte enthalten, die durch H2-Überschriften abgegrenzt sind. Jeder Abschnitt enthält eine Liste von Markdown-Hyperlinks, optional gefolgt von beschreibenden Notizen. Diese Struktur ermöglicht sowohl eine hierarchische Organisation als auch eine flache Zugänglichkeit - KI-Agenten können entweder das gesamte Dokument verarbeiten oder schnell bestimmte Abschnitte von Interesse finden.

Am genialsten ist vielleicht, dass die Norm einen optionalen Abschnitt „Optional“ enthält. Mit dieser cleveren Funktion können Anbieter von Inhalten angeben, welche Informationen ergänzend sind, so dass KI-Agenten intelligente Entscheidungen über die Verarbeitung von Inhalten innerhalb ihrer Kontextgrenzen treffen können.

Der Standard empfiehlt auch die Bereitstellung von Markdown-Versionen regulärer Webseiten durch Anhängen von .md an URLs. Dadurch wird eine parallele Inhaltsstruktur geschaffen, die für die KI-Nutzung optimiert ist, während die umfangreiche Formatierung und Interaktivität herkömmlicher Webseiten für menschliche Besucher erhalten bleibt.

Jenseits von Dateiformaten: Eine neue Web-Architektur

Aber llms.txt ist mehr als nur ein neues Dateiformat - es ist ein Einblick, wie sich die Architektur des Webs entwickelt, um KI-Agenten als Bürger erster Klasse aufzunehmen. Die herkömmliche Web-Architektur geht davon aus, dass die menschliche Nutzung im Vordergrund steht und die maschinelle Lesbarkeit erst in zweiter Linie berücksichtigt wird. Bei der neuen Architektur werden sowohl die menschliche als auch die künstliche Intelligenz als gleich wichtig angesehen, was zu neuen Mustern bei der Strukturierung und Bereitstellung von Inhalten führt.

Anstatt maschinenlesbare Inhalte erst nachträglich zu erstellen, könnten wir mit strukturierten Inhalten beginnen und sowohl menschen- als auch kI-freundliche Präsentationen aus derselben Quelle generieren. Content-Management-Systeme könnten parallele Versionen von Inhalten verwalten.

Dieser architektonische Wandel wirft faszinierende Fragen zu Autorität und Vertrauen in Inhalte auf. Im menschlichen Web verlassen wir uns stark auf visuelle und kontextbezogene Hinweise, um Vertrauenswürdigkeit zu schaffen. Wie können wir ähnliche Vertrauensmechanismen für von KI konsumierte Inhalte schaffen? Der llms.txt-Standard befasst sich nicht direkt mit dieser Frage, aber seine Struktur bietet Anknüpfungspunkte, an denen Vertrauensmechanismen implementiert werden könnten.

Die Zukunft ist multimodal

Im Laufe der Zeit wird das Web immer weniger zu einer Publikationsplattform und immer mehr zu einer multimodalen Kommunikationsinfrastruktur. Es ist ein Ort, an dem Menschen und KI nicht nur koexistieren, sondern aktiv zusammenarbeiten. Der llms.txt-Standard ist nur ein erstes Beispiel dafür, wie wir diese Zusammenarbeit strukturieren könnten.

Die vor uns liegenden Herausforderungen sind erheblich. Wir müssen neue Muster für die Erstellung von Inhalten entwickeln, die sowohl dem menschlichen als auch dem KI-Publikum effektiv dienen. Wir müssen Vertrauensmechanismen schaffen, die über verschiedene Konsumformen hinweg funktionieren. Wir müssen über Datenschutz und Zugangskontrolle auf neue Weise nachdenken.

Aber die Möglichkeiten sind noch viel aufregender. Stellen Sie sich ein Web vor, in dem KI-Agenten Informationen effizient verarbeiten und umsetzen können, während Menschen von reichhaltigeren, intuitiveren Schnittstellen profitieren. Stellen Sie sich Inhalte vor, die sich automatisch an ihren Nutzer anpassen, egal ob menschlich oder künstlich. Stellen Sie sich neue Formen der Zusammenarbeit zwischen Menschen und KI vor, die durch ein gemeinsames Verständnis von Webinhalten ermöglicht werden.

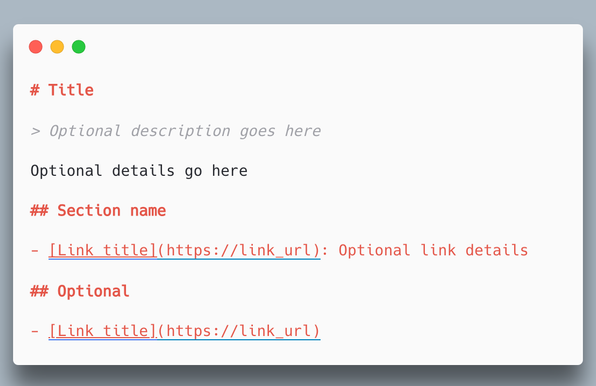

Ein praktisches Beispiel: Der Internetauftritt von IKANGAI

Schauen wir uns an, wie dies in der Praxis funktionieren könnte, indem wir IKANGAI, ein KI-Beratungs- und Implementierungsunternehmen, betrachten. Ihre derzeitige Website bietet menschlichen Besuchern umfangreiche Inhalte über ihre KI-Dienstleistungen, Workshops und Projekte. Hier sehen wir, wie sie mit llms.txt verbessert werden könnte:

# IKANGAI

> IKANGAI ist eine unabhängige Ideenfabrik, der sich auf KI-Integration und digitale Unternehmensberatung spezialisiert hat und 2009 gegründet wurde. Wir bieten KI-Workshops, strategische Beratung und maßgeschneiderte KI-Implementierungsdienste.

Wir setzen uns für Vertrauen, Innovation und gemeinsames Wachstum mit unseren Partnern ein. Unser Name leitet sich vom japanischen Wort „IIKANGAE“ ab und bedeutet „gute Idee“.

## Services

- [AI Workshops](https://ikangai.com/services/workshops.md): Umfassende praktische Workshops, die komplexe KI-Konzepte entmystifizieren

- [Strategic AI Consultation](https://ikangai.com/services/consultation.md): Kundenspezifische AI-Strategieentwicklung und Integrationsplanung

- [AI Tool Selection](https://ikangai.com/services/tools.md): ewertung und Empfehlung von maßgeschneiderten KI-Tools und -Plattformen

- [AI Projects](https://ikangai.com/services/projects.md): Kundenspezifische AI-Anwendungsentwicklung und Systemintegration## Projekte

- [SOLOMON Project](https://ikangai.com/projects/solomon.md): ITEA-Projekt zur Entwicklung einer „Shop Operations & Experience“-Plattform

- [Client Projects](https://ikangai.com/projects/clients.md): Überblick über vergangene und laufende Kundenprojekte## Optional

- [News](https://ikangai.com/news.md): Neueste Artikel über KI-Technologie und Einblicke in die Entwicklung

- [Team](https://ikangai.com/about/team.md): Informationen über unsere AI-Spezialisten und Berater

- [Contact](https://ikangai.com/contact.md): Kontaktinformationen und Standorte

Dieses strukturierte Format ermöglicht es KI-Agenten, die Angebote von IKANGAI schnell zu verstehen und auf relevante Informationen über ihre Dienste zuzugreifen. Die parallelen Markdown-Versionen der einzelnen Seiten würden saubere, kontextoptimierte Inhalte für die KI bereitstellen, während die Hauptwebsite den menschlichen Besuchern weiterhin das volle interaktive Erlebnis bietet.

Die Entwicklung des Webs von einem menschlichen Medium zu einer menschlich-intelligenten Infrastruktur ist nicht nur eine technische Veränderung, sondern auch ein grundlegender Wandel in der Art und Weise, wie wir über digitale Kommunikation denken. Bei der Bewältigung dieses Übergangs bieten Standards wie llms.txt wertvolle Erkenntnisse darüber, wie wir dieses neue, integrativere Web aufbauen können. In der Zukunft des Webs geht es nicht nur darum, dass Menschen durch Seiten klicken, sondern darum, eine Umgebung zu schaffen, in der Menschen und KI effektiv miteinander kommunizieren, zusammenarbeiten und gemeinsam etwas schaffen können.

Gehen Sie mit KI in die Zukunft Ihres Unternehmens

Mit unseren KI-Workshops rüsten Sie Ihr Team mit den Werkzeugen und dem Wissen aus, um bereit für das Zeitalter der KI zu sein.

Kontaktieren Sie unsThe llms.txt Standard and the Rise of Human-AI Infrastructure

The World Wide Web stands at the threshold of a profound transformation. A new proposal called llms.txt signals the emergence of something remarkable: a web that serves not just human readers, but artificial intelligences as first-class citizens. This isn't merely another technical standard—it's the beginning of a fundamental shift in how we think about digital infrastructure.

What makes this moment significant isn't just the technical specification, but what it represents: an acknowledgment that AI agents are becoming primary consumers of web content, not just intermediaries. As these agents evolve from simple crawlers to sophisticated decision-makers, our web infrastructure must evolve with them.

A Tale of Two Webs

When you visit a modern website, you're actually interacting with multiple layers of content. The visible layer—what you see in your browser—is a rich tapestry of HTML, CSS, and JavaScript, carefully crafted for human consumption. But beneath this surface lies another web, one designed for machines: APIs, structured data, and machine-readable formats that help search engines and other automated systems make sense of the content.

This duality has existed since the early days of search engines, when standards like robots.txt and sitemap.xml emerged to help crawlers navigate the web more effectively. But today, we're witnessing the emergence of a third layer: one specifically designed for AI agents that don't just index content, but actively consume, process, and act upon it.

The llms.txt Standard: A Bridge Between Worlds

Jeremy Howard's proposed llms.txt standard perfectly illustrates this evolution. It's a elegant solution to a complex problem: how do we help AI agents efficiently process web content while maintaining human readability? The standard suggests a simple yet powerful approach—a markdown file at the root of web servers that provides AI-friendly versions of key content.

The technical structure of llms.txt is worth examining in detail. Unlike traditional machine-readable formats like XML or JSON, it uses markdown—a format that strikes a careful balance between human and machine readability. The specification calls for a precise structure:

At the top level, every llms.txt file begins with an H1 header containing the site or project name, followed by a blockquote that succinctly summarizes the key information. This isn't just about organization—it's about providing context efficiently within the limited context windows of current AI models.

The real innovation comes in how the standard handles content organization. After the initial summary, the file can contain multiple sections delineated by H2 headers. Each section contains a list of markdown hyperlinks, optionally followed by descriptive notes. This structure allows for both hierarchical organization and flat accessibility—AI agents can either process the entire document or quickly locate specific sections of interest.

Perhaps most ingeniously, the standard includes an optional "Optional" section. This clever feature allows content providers to indicate which information is supplementary, helping AI agents make intelligent decisions about content processing within their context limitations.

The standard also recommends providing markdown versions of regular web pages by appending .md to URLs. This creates a parallel content structure that's optimized for AI consumption while maintaining all the rich formatting and interactivity of traditional web pages for human visitors.

Beyond File Formats: A New Web Architecture

But llms.txt represents more than just a new file format—it's a glimpse into how the web's architecture is evolving to accommodate AI agents as first-class citizens. Traditional web architecture assumes human consumption as the primary use case, with machine readability as an afterthought. The emerging architecture treats both human and AI consumption as equally important, leading to new patterns in how we structure and serve content.

Consider how this might change how we build websites. Instead of generating machine-readable content as an afterthought, we might start with structured content and generate both human and AI-friendly presentations from the same source. Content management systems might maintain parallel versions of content.

This architectural shift raises fascinating questions about content authority and trust. In the human web, we rely heavily on visual and contextual cues to establish trustworthiness. How do we establish similar trust mechanisms for AI-consumed content? The llms.txt standard doesn't directly address this, but its structure provides hooks where trust mechanisms could be implemented.

The Future is Multi-Modal

As we move forward, the web is becoming less of a publication platform and more of a multi-modal communication infrastructure. It's a place where humans and AIs not only coexist but actively collaborate. The llms.txt standard is just one early example of how we might structure this collaboration.

The challenges ahead are significant. We need to develop new patterns for content creation that serve both human and AI audiences effectively. We need to establish trust mechanisms that work across different modes of consumption. We need to think about privacy and access control in new ways.

But the opportunities are even more exciting. Imagine a web where AI agents can efficiently process and act upon information, while humans enjoy richer, more intuitive interfaces. Imagine content that automatically adapts to its consumer, whether human or artificial. Imagine new forms of collaboration between humans and AIs, enabled by shared understanding of web content.

A Practical Example: IKANGAI's Web Presence

Let's look at how this might work in practice by considering IKANGAI, an AI consulting and implementation company. Their current website serves human visitors with rich content about their AI services, workshops, and projects. Here's how it could be enhanced with llms.txt:

# IKANGAI

> IKANGAI is an independent solutions factory specializing in AI integration and digital business consulting, founded in 2009. We provide AI workshops, strategic consultation, and custom AI implementation services.

We champion trust, innovation, and collaborative growth with our partners. Our name comes from the Japanese word "IIKANGAE" meaning "good idea."

## Services

- [AI Workshops](https://ikangai.com/services/workshops.md): Comprehensive hands-on workshops that demystify complex AI concepts

- [Strategic AI Consultation](https://ikangai.com/services/consultation.md): Custom AI strategy development and integration planning

- [AI Tool Selection](https://ikangai.com/services/tools.md): Assessment and recommendation of tailored AI tools and platforms

- [AI Projects](https://ikangai.com/services/projects.md): Custom AI application development and system integration## Projects

- [SOLOMON Project](https://ikangai.com/projects/solomon.md): ITEA project developing a "shop operations & experience" platform

- [Client Projects](https://ikangai.com/projects/clients.md): Overview of past and ongoing client implementations## Optional

- [News](https://ikangai.com/news.md): Latest articles on AI technology and development insights

- [Team](https://ikangai.com/about/team.md): Information about our AI specialists and consultants

- [Contact](https://ikangai.com/contact.md): Contact information and office locations

This structured format would allow AI agents to quickly understand IKANGAI's capabilities and access relevant information about their services. The parallel markdown versions of each page would provide clean, context-optimized content for AI consumption, while the main website continues to serve human visitors with its full interactive experience.

The web's evolution from a human medium to a human-AI infrastructure isn't just a technical shift—it's a fundamental change in how we think about digital communication. As we navigate this transition, standards like llms.txt provide valuable insights into how we might build this new, more inclusive web. The future of the web isn't just about humans clicking through pages—it's about creating an environment where humans and AIs can effectively communicate, collaborate, and create together.

Unlock the Future of Business with AI

Dive into our immersive workshops and equip your team with the tools and knowledge to lead in the AI era.

Get in touch with us Revolutionizing Web Content for #AI Consumption

#llmstxt proposes new web standard with `/llms.txt` files, making websites more accessible to #LLM systems while maintaining human readability

Features implemented in projects like #FastHTML and supported by #nbdev:

• Standardized #markdown format for structured content delivery

• Clean, parseable documentation with `.md` extensions

• Complementary to existing standards like robots.txt and sitemap.xml

Technical Implementation:

• #Python CLI tool and module available for parsing

• #JavaScript implementation for web integration

• Supports automated content processing and context generation

Use Cases:

• Software documentation

• Corporate information

• Educational resources

• Portfolio websites

• E-commerce platforms

Learn more: https://llmstxt.org/